范式智能发布Fusion-NAND|专为OpenMLDB打造的高效存储扩展卡 以近内存性能破解AI实时计算成本困局

2025-11-14

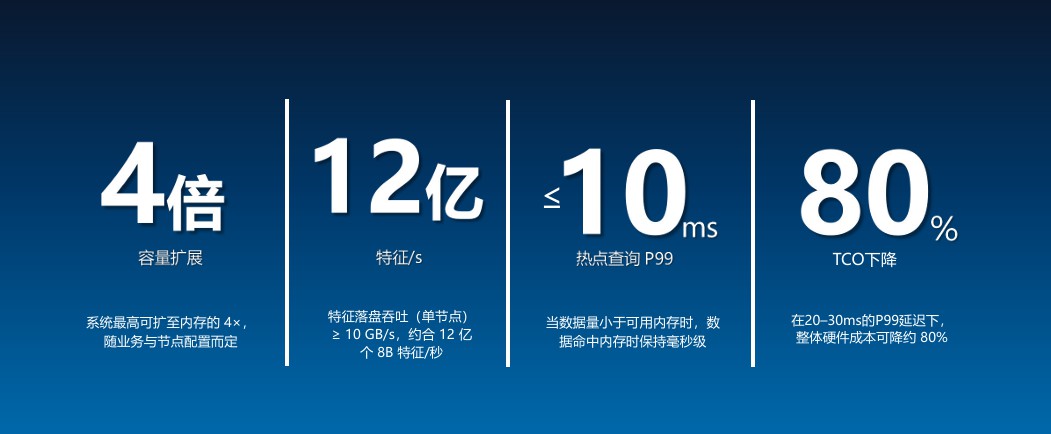

01 AI特征工程的“一致性”挑战与OpenMLDB的破局OpenMLDB:是范式智能开源的一套面向机器学习场景的数据库系统主要解决:“训练时用的特征”和“线上实时推理时用的特征”不一致的问题核心目标:写一套特征逻辑,离线能跑,线上也能跑,结果要一致、也要快AI模型的效能高度依赖高质量的特征数据。然而,业界长期面临一个核心痛点:离线训练与在线推理场景下的特征不一致。数据科学家在离线环境(如使用Python/Spark)开发的特征逻辑,往往难以直接、高效且一致地复用于要求毫秒级响应的线上服务。这导致了模型上线后效果打折、研发流程割裂以及沉重的工程重构负担。OpenMLDB作为一套面向机器学习场景的开源数据库系统,精准地解决了这一难题。其核心价值在于“一次建模,多端复用”,通过统一的SQL定义,同时支持离线的批量特征计算用于模型训练,以及在线的实时特征抽取用于模型推理,确保线上线下特征的一致性,并满足实时业务的高性能要求。OpenMLDB已成为众多企业构建敏捷、可靠AI应用的核心“AI大脑”。尽管OpenMLDB高效地统一了特征逻辑,但在处理长周期时间窗口(例如,分析用户过去数月的行为以进行信贷风险评估)时,需要快速扫描海量的历史数据。传统做法是将全部数据置于内存(DRAM)中以保证性能,但随着数据量的持续增长,内存容量告急,增加内存带来的成本增加,成为企业规模化应用AI的“拦路虎”。范式智能推出的Fusion-NAND,正是为解决上述成本与性能的矛盾而生。我们可以将其形象地理解为:为OpenMLDB这个“AI大脑”定制了一个超大号的“超级内存”。它并非通用存储设备,而是一款深度定制、软硬协同的高性能存储产品,其核心价值在于以极具竞争力的成本,实现近似内存的扩展能力与访问体验。容量与成本革命:以最高4倍容量扩展,实现最高TCO降低80%Fusion-NAND使系统有效存储容量最高可扩展至纯内存方案的4倍,轻松应对长窗口、海量历史特征数据的存储需求。在满足20-30毫秒P99延迟的业务场景下,能够将整体硬件成本最高直降约80%,打破海量数据实时分析的成本枷锁。性能卓越:单节点12亿特征/秒落盘吞吐能力,P99延迟稳定在毫秒级凭借PCIe 5.0接口与高效的用户态直通技术(SPDK/io_uring),Fusion-NAND可提供单节点≥10GB/s的特征落盘吞吐能力,约合每秒处理12亿个8字节特征。通过智能冷热数据分层,当查询命中内存中的热点数据时,其P99延迟可最优稳定在10毫秒以内,提供逼近内存的实时响应体验。产品提供从2TB至8TB的企业级容量梯度,采用3D TLC介质与顺序写友好策略,有效降低写放大(WAF)。全系支持AES-256即时加密、TCG Opal 2.0安全协议及安全擦除功能,保障数据安全。同时,其具备断电保护(PLP)、超过200万小时MTBF及宽温工作范围,确保在苛刻的生产环境中稳定运行,万无一失。在AI落地的深水区,基础设施的精细化创新是释放业务价值的关键,Fusion-NAND与OpenMLDB的深度结合,破解了“既要海量历史数据,又要实时低延迟,还要控制成本”的不可能三角。我们相信,Fusion-NAND的推出,不仅强化了OpenMLDB在机器学习数据生态中的核心竞争力,也为广大面临AI计算成本压力的企业提供了切实可行的破局之道,这将成为推动AI技术在各行各业规模化普及的重要助推器。